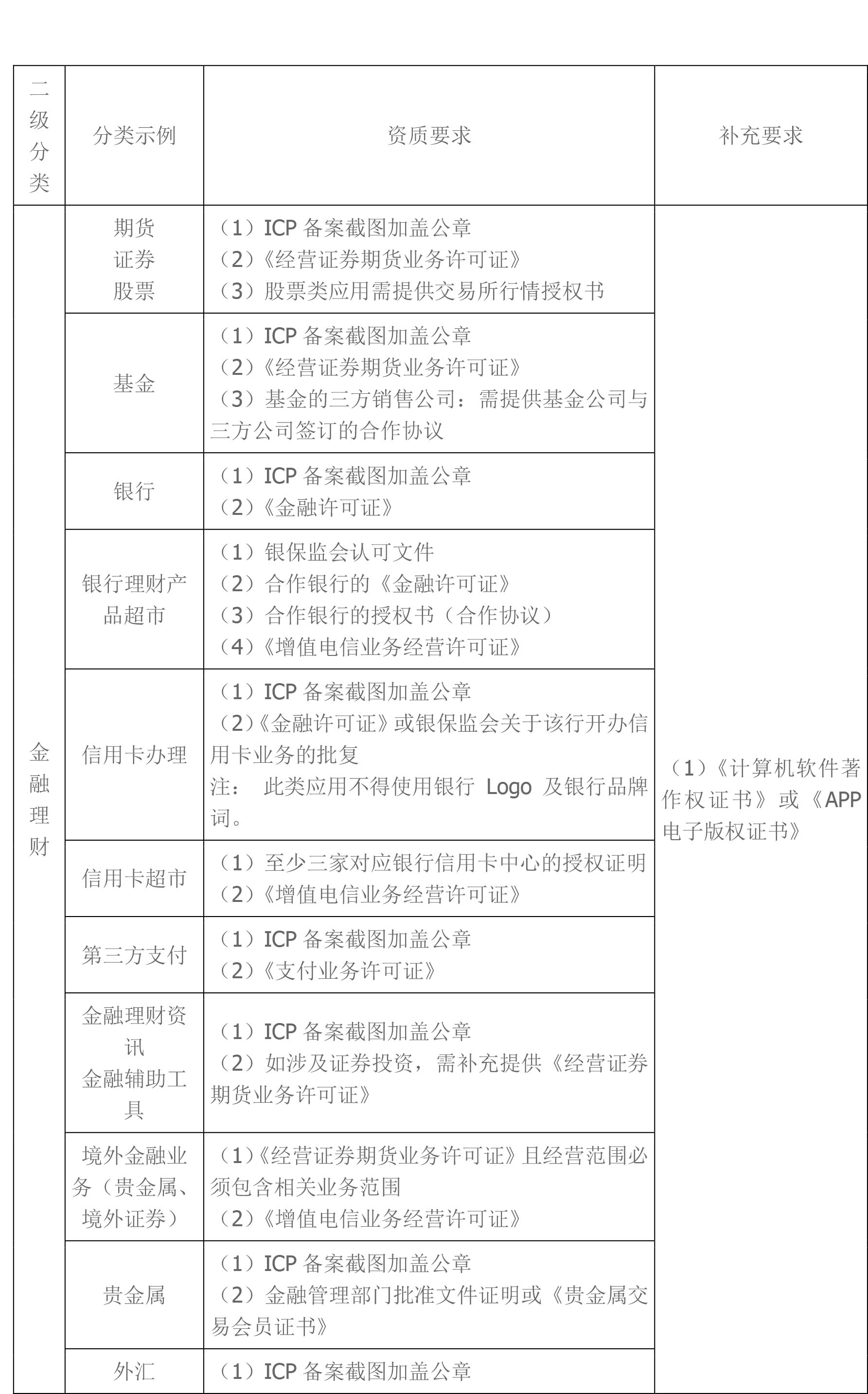

TF(TensorFlow)是一种流行的机器学习框架,由Google开发并维护。它可以在多种平台上运行,包括桌面、移动设备和云端。在苹果设备上,TF可以通过Core ML框架来实现。Core ML是苹果公司推出的一种机器学习框架,它可以将训练好的模型转换成可以在iOS设备上运行的格式。在本文中,我们将介绍如何将TF模型转换成Core ML格式并在iOS设备上使用。

1. 准备工作

在开始之前,我们需要确保已经安装了以下软件:

- TensorFlow 1.13或更高版本

- Xcode 10或更高版本

- TensorFlow的Python API

2. 导出TF模型

首先,我们需要在Python中定义一个TF模型,并将其导出为一个pb文件。这个pb文件包含了TF模型的所有权重和结构信息。

导出模型的代码如下:

```python

import tensorflow as tf

# 定义模型

input_tensor = tf.placeholder(tf.float32, shape=[None, 28, 28, 1], name='input_tensor')

conv1 = tf.layers.conv2d(inputs=input_tensor, filters=32, kernel_size=[5, 5], padding='same', activation=tf.nn.relu)

pool1 = tf.layers.max_pooling2d(inputs=conv1, pool_size=[2, 2], strides=2)

conv2 = tf.layers.conv2d(inputs=pool1, filters=64, kernel_size=[5, 5], padding='same', activation=tf.nn.relu)

pool2 = tf.layers.max_pooling2d(inputs=conv2, pool_size=[2, 2], strides=2)

flatten = tf.layers.flatten(inputs=pool2)

dense1 = tf.layers.dense(inputs=flatten, units=1024, activation=tf.nn.relu)

dropout = tf.layers.dropout(inputs=dense1, rate=0.4)

logits = tf.layers.dense(inputs=dropout, units=10)

# 导出模型

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

saver = tf.train.Saver()

saver.save(sess, 'model.ckpt')

tf.train.write_graph(sess.graph_def, '.', 'model.pb', as_text=False)

```

这个代码定义了一个简单的卷积神经网络,用于对MNIST手写数字数据集进行分类。我们将这个模型导出为一个pb文件,并将它保存在当前目录下。

3. 转换为Core ML格式

接下来,我们需要将pb文件转换为Core ML格式。为此,我们可以使用Apple提供的tfcoreml工具。这个工具可以自动将TF模型转换为Core ML格式,并生成Swift或Objective-C代码,用于在iOS应用中使用。

首先,我们需要安装tfcoreml工具。在终端中输入以下命令:

```bash

pip install tfcoreml

```

安装完成之后,我们可以使用以下命令将pb文件转换为Core ML格式:

```bash

tfcoreml.convert(tf_model_path='model.pb',

mlmodel_path='model.mlmodel',

output_feature_names=['dense_1/BiasAdd:0'],

input_name_shape_dict={'input_tensor:0': [None, 28, 28, 1]},

image_input_names=['input_tensor:0'],

image_scale=1/255.0)

```

这个命令将pb文件转换为Core ML格式,并将其保存为model.mlmodel文件。其中,output_feature_names参数指定了输出节点的名称,input_name_shape_dict参数指定了输入节点的名称和形状,image_input_names参数指定了图像输入的节点名称,image_scale参数指定了图像像素值的缩放因子。

4. 在iOS应用中使用

现在,我们已经将TF模型转换为了Core ML格式,并将其保存为了model.mlmodel文件。接下来,我们可以在iOS应用中使用这个模型进行推断。

在Xcode中创建一个新的iOS应用,并将model.mlmodel文件添加到项目中。然后,在ViewController.swift文件中添加以下代码:

```swift

import UIKit

import CoreML

class ViewController: UIViewController {

override func viewDidLoad() {

super.viewDidLoad()

let model = MNIST()

guard let image = UIImage(named: "test.png"), let pixelBuffer = image.pixelBuffer() else {

fatalError()

}

guard let output = try? model.prediction(input_tensor: pixelBuffer) else {

fatalError()

}

print(output.classLabel)

}

}

extension UIImage {

func pixelBuffer() -> CVPixelBuffer? {

let width = Int(self.size.width)

let height = Int(self.size.height)

let attrs = [kCVPixelBufferCGImageCompatibilityKey: kCFBooleanTrue,

kCVPixelBufferCGBitmapContextCompatibilityKey: kCFBooleanTrue] as CFDictionary

var pixelBuffer: CVPixelBuffer?

let status = CVPixelBufferCreate(kCFAllocatorDefault,

width,

height,

kCVPixelFormatType_OneComponent8,

attrs,

&pixelBuffer)

guard let buffer = pixelBuffer, status == kCVReturnSuccess else {

return nil

}

CVPixelBufferLockBaseAddress(buffer, CVPixelBufferLockFlags(rawValue: 0))

defer {

CVPixelBufferUnlockBaseAddress(buffer, CVPixelBufferLockFlags(rawValue: 0))

}

let pixelData = CVPixelBufferGetBaseAddress(buffer)

let rgbColorSpace = CGColorSpaceCreateDeviceGray()

guard let context = CGContext(data: pixelData,

width: width,

height: height,

bitsPerComponent: 8,

bytesPerRow: CVPixelBufferGetBytesPerRow(buffer),

space: rgbColorSpace,

bitmapInfo: CGImageAlphaInfo.none.rawValue) else {

return nil

}

context.translateBy(x: 0, y: CGFloat(height))

context.scaleBy(x: 1, y: -1)

UIGraphicsPushContext(context)

self.draw(in: CGRect(x: 0, y: 0, width: self.size.width, height: self.size.height))

UIGraphicsPopContext()

return pixelBuffer

}

}

```

这个代码使用Core ML框架对一个手写数字图像进行分类。它首先加载了model.mlmodel文件,并将图像转换为一个CVPixelBuffer对象